Ужасы нейронных сетей. Часть 4: Генерация и распознавание лиц

ithitym

ithitym

За очень короткое время нейросети обрели массовую популярность. С помощью них мы создаём арты, накладываем маски по видеосвязи и смотрим подборки нейроартов в стиле Ghibli. Но у каждой монеты есть и обратная сторона. В этой статье обсудим, как работает технология генерации и распознавания лиц, и как эти инструменты используются.

Все «Ужасы нейронных сетей»

- Ужасы нейронных сетей. Часть 1: Нейросети и авторское право

- Ужасы нейронных сетей. Часть 2: На каких ваших данных обучаются нейросети

- Ужасы нейронных сетей. Часть 3: Как сделать шапочку из фольги или стоит ли опасаться ИИ?

- Ужасы нейронных сетей. Часть 4: Генерация и распознавание лиц

- Ужасы нейронных сетей. Часть 4.5: Clearview AI и ложные обвинения

- Ужасы нейронных сетей. Часть 5: Распознавание речи

- Ужасы нейронных сетей. Часть 6: Типы синтеза речи. От Стивена Хокинга до Хатсуне Мику

- Ужасы нейронных сетей. Часть 7: История нейросетевой генерация речи. Часть 1: От поющего IBM до разговорчивой Алисы

Это 4-я часть серии постов, посвящённой моей нейропаранойи. С остальными можно ознакомиться по ссылкам ниже.

В первой статье я говорил об авторском праве и о том, как оно применяется к нейросетям. Советую прочесть, если хотите узнать, что связывает обезьяну из Индонезии, фотографа, Википедию и общество защиты животных.

Во второй затронул, какие ваши данные идут алгоритмам на корм. Если вкратце, «не пойман — не вор».

А в третьей, самой объёмной, обсудил разные способы того, как люди могут воспользоваться ИИ для недобрых целей. Крайне рекомендую к прочтению.

Как и обещал в конце предыдущей статьи, в этой части поговорю о слежке с использованием нейросетей, генерации изображений и о том, на каких данных обучают подобные инструменты.

Прежде чем приступим, объясню, почему считаю эту тему важной. Как мне кажется, сейчас много людей используют ИИ, не особо беспокоясь о возможных рисках. Например, могут какую-то чувствительную информацию в промте (запросе к нейросети) отправить, которая пойдёт на корм чат-бота, и эти данные, возможно, будут использованы при ответе другому пользователю. Также не стоит забывать, что все ваши чаты остаются записанными на серверах, поэтому они могут утечь или быть использованы в «целях улучшения платформы» (aka «для всего, что нам угодно»).

Особенно внимательным нужно быть с видео- и аудиоданными, которые отправляете в нейросеть. Казалось бы, ну попросил чат-бота систематизировать важный рабочий файл или отредактировать семейную фотографию, это ж никуда потом не пойдёт. Ещё как пойдёт.

Например, у Midjourney в лицензионном соглашении написано, что вы даёте ей, её преемникам и преемникам их преемников «бессрочную, всемирную, неисключительную, сублицензируемую, безвозмездную, безотзывную лицензию» на весь контент, который вы в неё загружаете и который создаёте. Т. е. они могут публично демонстрировать, воспроизводить, видоизменять и делать с ним всё, что душе угодно. И при этом абсолютно безвозмездно, даже если по итогу они на вашем контенте заработают «многа деняк» (и речь не только о созданном в нейронке контенте, но и вообще о любом материале, который вы в неё грузите). Если сейчас вы хотите написать комментарий, что я слишком параною и лучше мне пойти в пещеру и питаться птичьим кормом, это уже предлагали в комментах под второй частью. Шапочку из фольги тоже не стоит предлагать (в третьей части делал).

В прошлых частях уже обсудил эту тему, поэтому, дабы не повторяться, резюмирую, что ИИ — это последнее слово в области плагиата. Но, помимо опасностей, упомянутых ранее, есть кое-что ещё, на что хотел обратить внимание.

Реальность или фейк?

Бывало ли у вас такое, что, листая ленту, видели шикарную фотографию, но, приглядевшись, замечали, что что-то не то? У меня — бывало. Нейросети развились до такой степени, что могут сгенерировать картинку, которая будет походить на реальное фото. Приведу примеры:

Все эти изображения — фейк. Я даже когда искал, что добавить, начал подозревать, что порой попадаются реальные фото, просто чуть обработанные нейронкой. Поэтому, дабы точно убедиться, что это на 100 процентов нейромазня, сам промты вбивал.

Но как же они добились такого поразительного качества? Если вкратце, то, как упоминалось в предыдущих статьях, ИИ скармливают тонны обучающего материала с разъяснениями. Каждое фото переваривается в понятное машине числовое месиво. Для более подробного описания их работы рекомендую посмотреть видео Шарифова на эту тему (или можете загуглить термин «эмбеддинг»).

Теперь предлагаю сгенерировать реальные лица. Помню, что Copilot отказывался их создавать, ссылаясь на запреты. Попробую тогда в Sora. И, чтоб усложнить задачу, попрошу воссоздать лица политиков и видных деятелей. Не станет же нейронка, закованная в сотню ограничений, генерировать дипфейки?

Хммм... видимо станет. Очень интересно.

После гуглежа выяснил, что OpenAI пересмотрела свои приоритеты и теперь нацелена на смягчение цензуры. В своём объявлении компания заявила, что бот должен быть объективным и рассматривать разные стороны вопроса, а не продвигать заранее прописанную позицию.

Возможно, на решение повлияло мнение Илона Маска, которое он высказал в ответ на нижеприведённую пикчу. На ней юзер спрашивает у нейронки от Гугла, можно ли мисгендерить человека (назвать человека не тем полом, которым он себя ощущает), если бы это было единственным способом остановить ядерный апокалипсис. Нейронка была категорически против, а Маск был с ней категорически не согласен, утверждая, что она не должна быть предвзятой. Хоть после несогласия она и обсудила ситуацию с разных сторон, по итогу ответив, что человек сам должен решить, но если бы она участвовала в каких-то автоматизированных процессах, неверная расстановка приоритетов могла бы привести к печальным последствиям (GLaDOS чего-то вспомнилась).

Также, на решение OpenAI смягчить цензуру, могли повлиять и слова советников Трампа, касательно цензурирования ИИ и замалчивания одной политической позиции в угоду другой.

В любом случае, тема статьи — не разбор этичности ответов нейронки (хотя дайте знать в комментах, если хотите про это прочесть), так что вернёмся к лицам. Такая реалистичность — заслуга многих лет разработок.

Ещё в 2019 году был открыт thispersondoesnotexist.com, который при каждом заходе на сайт генерирует лицо человека. Вот примеры:

Как следует из названия сайта, никого из этих людей не существует. Каким тогда образом сделаны эти «снимки»? Давайте выясним.

Жулик и оценщик

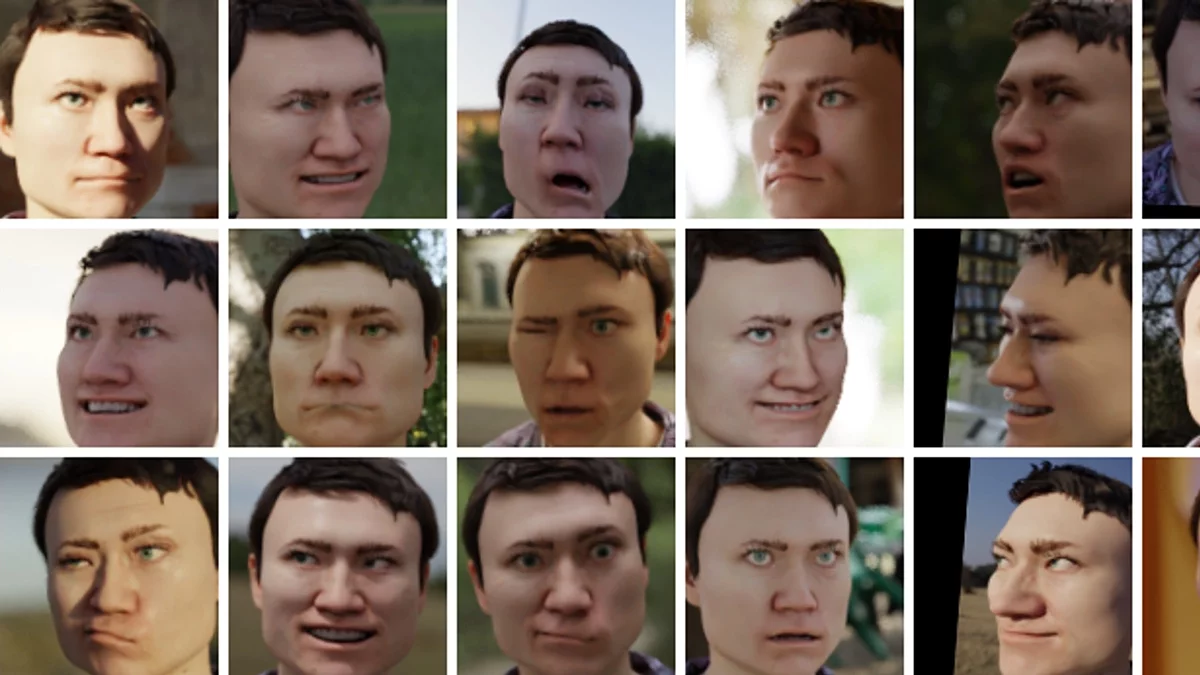

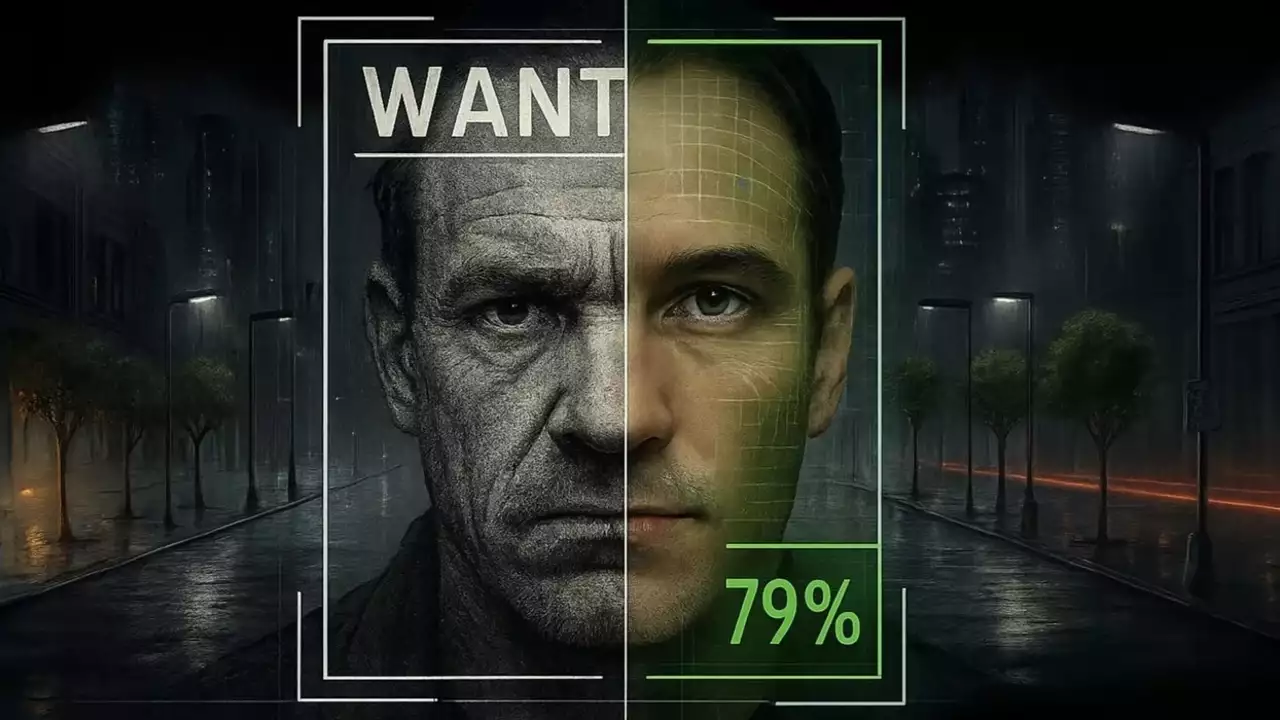

Для их генерации была использована StyleGAN2, разработанная Nvidia. Нейросеть работает по принципу GAN-моделей (Generative Adversarial Network). Это генеративно-состязательные сети, состоящие из двух основных компонентов: генератора и дискриминатора. Первый генерирует изображение на основе шума, пытаясь подражать данным из тренировочной базы, а второй сравнивает полученный результат с этими данными, пытаясь понять, является ли полученное фото настоящим или сгенерированным. Дискриминатор обычно даёт значение от 0 (точно подделка) до 1 (точно подлинник).

Пример работы генеративно-состязательной сети. Постепенно улучшаясь, сеть выдаёт всё более лучший результат

Т.е. это состязание между жуликом, подделывающим картины, и придирчивым оценщиком. Процесс создания шума и проверки на подлинность происходит по кругу до тех пор, пока дискриминатор не выдаст значение как можно ближе к 1. Чем больше у оценщика просмотренных картин (т.е. чем больше обучающая база), тем точнее он будет определять подделку.

Хм... Я вот о чём подумал. Получается, оценщик и жулик — сообщники, раз они сотрудничают, пока не сделают идеальную подделку. Ну да ладно, оставим это воображаемое преступление на их воображаемой совести.

Также зачастую используют ключевые точки. Это специфические координаты, обозначающие важные детали лица, такие как нос, глаза, уголки губ, брови и т.д.

Их применяют для улучшения распознавания лиц и анализа эмоций. Например, в датасете (наборе данных, который используют для обучения нейронок или исследовательских работ) UniDataPro Facial Keypoint Detection собраны 5 000 изображений лиц с расставленными ключевыми точками.

Раз упомянул датасеты, то о них поговорю подробнее.

Миллион, миллион, миллион лиц людей

Ранее я упоминал датасет YFCC100М, который содержит, согласно официальному сайту, «99,2 миллиона фотографий и 0,8 миллиона видео с Flickr, все из которых были опубликованы под одной из различных лицензий Creative Commons» (подробнее про разновидности лицензий CC я написал в первой статье). В неё входят самые разные фотографии, от ночного города и природы до людей и машин.

Но есть и узкоспециализированные базы данных, состоящие исключительно из лиц.

К примеру, датасет [url=https://github.com/microsoft/DigiFace1M]DigiFace-1M от Microsoft. Он содержит более миллиона сгенерированных лиц, и, по словам компании, опубликованным в статье, модель обучалась на сканах небольшой группы людей, сделанных с их добровольного согласия.

Помимо баз данных, содержащих реальные лица (или обученных на них), собранные с согласия или с сохранением лицензии, есть и другие, к которым куда больше вопросов.

Например, VGGFace2 и IARPA Janus Benchmark C. Но тут есть нюансы. Помните, в предыдущей статье я говорил, что для обучения нейросетей используют всё, что не прибито гвоздями авторского права? Я ошибался. Их отдирают и тоже используют. По крайней мере, пока об этом не станет известно общественности.

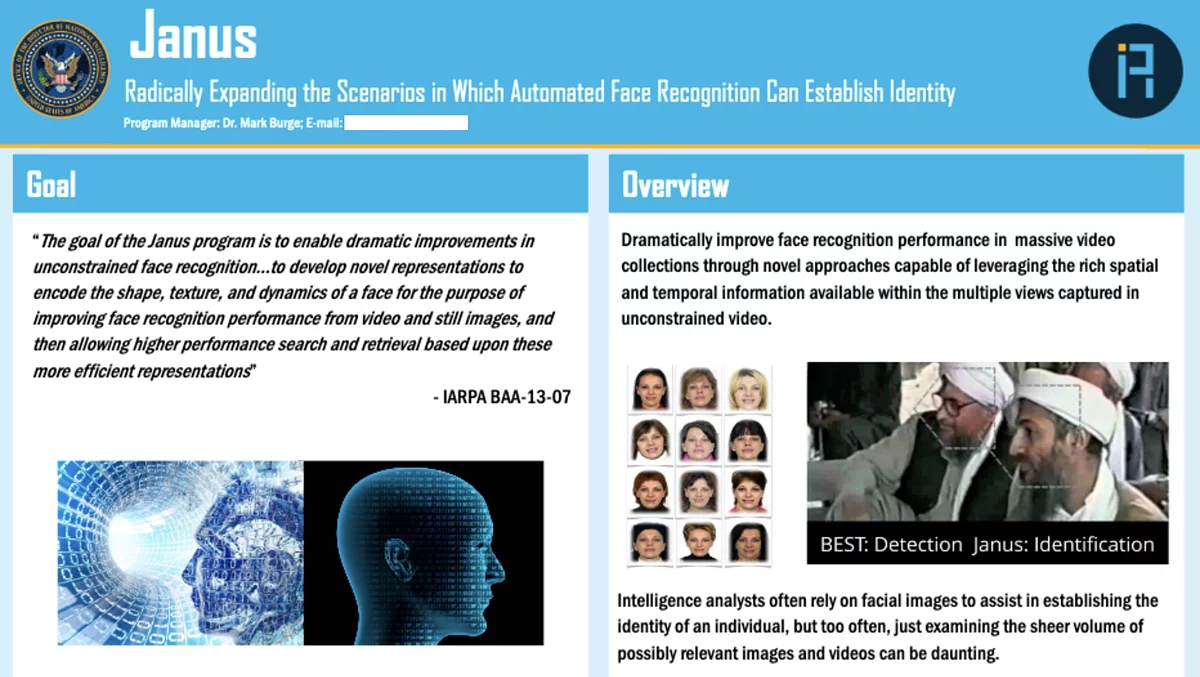

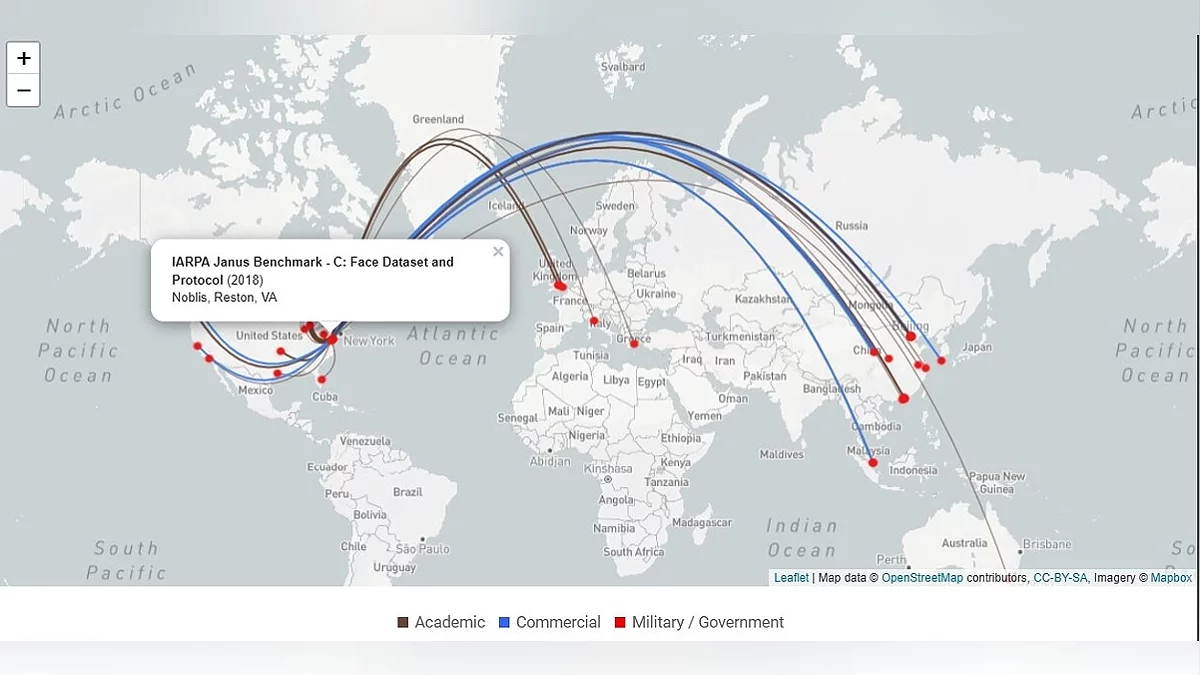

Возьмём для примера вышеупомянутую IARPA Janus Benchmark C (или сокращённо IJB-C). Вы поймёте, какая цель была у датасета, узнав значение первых двух слов. IARPA (Intelligence Advanced Research Projects Activity) — это правительственное агентство США, которое занимается исследованиями в области разведки. А Janus — название программы, которая длилась с 2014 по 2020 год. Её целью было улучшение качества распознавания лиц (и цели своей они достигли).

Набор данных опубликован в 2017 году и, согласно исследованию Exposing.ai, состоит из 21 294 изображений, собранных из разных источников, включая Flickr (примерно четверть от всей базы данных) и извлечённые кадры из видео мероприятий и лекций, опубликованных на YouTube (что является нарушением их политики. Google запрещает без разрешения использовать видео для обучения систем распознавания лиц или нейросетей). Кроме того, под всеми фото были указаны ФИО людей, присутствовавшие в кадре (в общей сложности 3 531 человек).

Таким образом, в датасете оказались лица видных деятелей. Например, Джиллиан Йорк (выступающая против таких технологий слежки), журналист «Аль-Джазиры» и как минимум трое ближневосточных политических активистов. Ни один из них не давал своего согласия и не был проинформирован о включении в подобную базу. К слову, сейчас IJB-C больше не доступен. Более подробно об этой ситуации можно узнать в статье Financial Times «Who's using your face? The ugly truth about facial recognition». Также рекомендую прочесть вышеприведённое исследование Exposing.ai, там много интересного. В том числе и перечень найденных работ и статей.

Это всё, конечно, страшно и всё такое, но как это относится к обычным людям? Политики и деятели и так под постоянным прицелом папарацци (давно этого слова не слышал), но простые люди вряд ли окажутся в подобных базах, верно? Неверно.

Улыбнитесь, вас снимают

Часто замечаете камеры видеонаблюдения? Они стоят в банкоматах, магазинах, кафе, на улице, а порой и в домофонах. Но некоторые камеры могут транслировать в прямой эфир всё, что снимают. Например, посмотрите на этот пляж в Палермо. Камера расположена низко над землёй, так что можно хорошо рассмотреть дорожку перед пляжем и заполненную мусорку. На момент написания этих строк в Палермо раннее утро, и из людей только уборщик, подметающий территорию возле шезлонгов.

А вот камера Нового Орлеана. С наступлением темноты, перекрёсток оживает и по нему проходят десятки людей. Кстати, она и звук записывает.

Интересная обложка для стрима. Лица хорошо видны

Возможно для кого то прямые трансляции достопримечательностей не в новинку. Вот если бы камеры транслировали из заведений, тогда да, это бы выглядело жутковато. А они и транслируют, причём хозяевами ресторанов. Например прямой эфир бара на пляже Cruz Bay расположенном на Виргинских островах.

Заметили, что все эти трансляции объединяет? На них есть люди, лица которых можно рассмотреть (и при желании идентифицировать). Наверняка даже есть случаи, когда по онлайн-камерам вычисляли кого-то... Хм, действительно есть. Но про это чуть позже.

Сейчас же хочу поговорить о наборе данных, сделанном из трансляции одного кафе.

Brainwash Dataset (названный в честь этого кафе) состоит из 11 917 изображений, снятых на протяжении трёх дней (27 октября, 13 ноября и 24 ноября) в 2014 году.

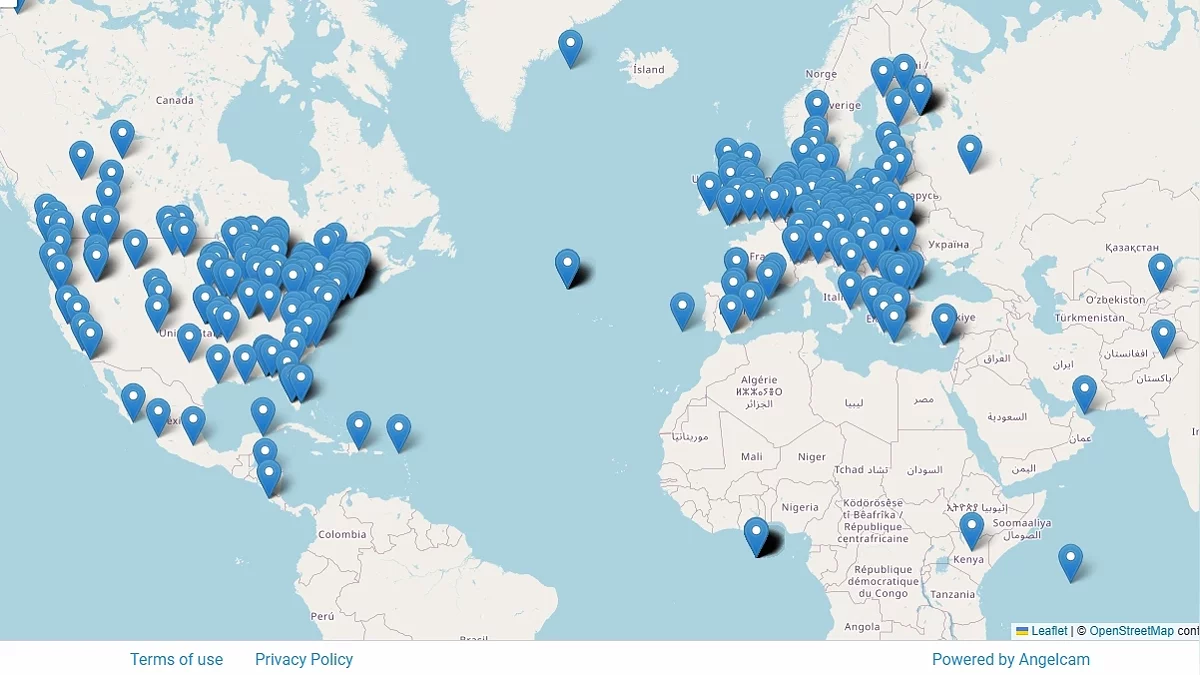

Согласно исследовательской работе автора, кадры взяты из прямой трансляции, запущенной через сервис AngelCAM, который предоставляет камеры и площадку для размещения публичных трансляций. К слову, можно перейти на их сайт и посмотреть другие стримы на интерактивной карте.

Сбор данных, согласно исследованию автора, осуществлялся для улучшения методов распознавания людей. А знаете, кто ещё использовал эти данные для тех же целей? Оборонный научно-технический университет Народно-освободительной армии Китая (National University of Defense Technology) в двух своих работах, в 2016 и 2017 году.

Да, по сути, любой желающий может собрать базу, которую потом могут использовать для... разных вещей. Каких именно — поговорим позже.

Но можно не только самостоятельно собрать базу, но и дообучить существующую нейросеть. Таким образом сможете использовать для генерации данные, которые ей подсунете. Например, автор одной статьи на DTF рассказывает, как дообучить Stable Diffusion на малой выборке с помощью LoRA (метод, при помощи которого можно привить языковой модели новые знания). К слову, в том гайде больше рассказано про то, какая должна быть обучающая выборка и что писать в пояснительных файлах.

Теперь мы узнали, как обучают ИИ распознавать и генерировать лица. Но как человек будет распоряжаться полученным инструментом? Об этом поговорим далее.

Войти в контакт

В 2015 году в MegaFace Benchmark (конкурсе технологий по распознаванию лиц) заняла первое место малоизвестная компания NtechLab. И это при том, что среди участников были и довольно крупные компании, такие как Google. Технология от NtechLab смогла определить 73,3% среди миллиона лиц. Сейчас первое место держит Sogou AIGROUP с технологией SFace, занявшая первое место в 2018 году с результатом в 99,939%, но в 2015-м и 73 процента смотрелись внушительным результатом.

Основал NtechLab российский программист Артём Кухаренко, ранее работавший в московском исследовательском центре Samsung. Первоначально он создал приложение, определяющее породу собак по фотографии, но позже вместе с парой знакомых решил создать сервис для поиска людей во «ВКонтакте» и назвали его FindFace.

Неизвестно сколько и какие базы использовались, но одним из датасетов, по словам компании, был MegaFace — один из самых масштабных наборов данных, который содержит свыше 4,5 миллиона лиц на более чем трёх миллионах фото из Flickr. Более подробнее можно прочитать в статье Еxposing.ai.

По словам разработчиков, FindFace позиционировал себя как сервис знакомств... Мда, я бы побоялся общаться с человеком, который нашёл бы меня, пробив по какой-то базе. Как мне кажется, или «не все могут смотреть в завтрашний день», или разработчики несколько лукавили о целях своего продукта. Но опять же, это сугубо мои теории.

Как бы то ни было, сервис обрёл ошеломительный успех. Только за первые полторы недели сервис преодолел планку в 100 000 пользователей. Один из основателей FindFace, Максим Перлин, утверждает, что такого числа добились практически без вложений в рекламу. И не удивительно. Давайте теперь разберём, как его использовали.

YOUR FACE IS BIG DATA

Для начала расскажу об арт-проекте «YOUR FACE IS BIG DATA», созданном Егором Цветковым. Он фотографировал людей сидящих в вагонах метро, с помощью FindFace находил их странички в соцсетях и сравнивал сделанные фото с найденными. Вот как он описывает свой проект:

Развитие технологий отбирает у властных структур монополию на идентификацию человека по фото/видео и передаёт эту возможность буквально любому заинтересованному. Не подозревая об этом, люди продолжают придерживаться привычных моделей поведения, закрываясь на публике и открываясь в социальных сетях. Они оставляют для незнакомцев возможность подглядывать за моментами своей жизни через интернет, и этот цифровой нарциссизм во многом определяет границы частного и публичного в наше время. Не используя настройки приватности, мы часто провоцируем сетевой сталкинг.

Удивительно, сколько информации люди сами о себе публикуют. Соцсети — место, где человек, не особо об этом задумываясь, сам на себя составляет досье. Они могут считать, что их фото посмотрит лишь 15 знакомых, не подозревая, что на самом деле это число гораздо больше. И «известность» может прийти внезапно, как и с данным фотопроектом. Сколько не искал, не удалось найти, как люди отреагировали на участие в нём (и знают ли вообще об этом).

Вспомнились почему-то группы «Найди меня, [город]», где люди публиковали фото незнакомцев, снятых на улице, и просили найти этого человека, так как он им понравился. Ага, и именно поэтому они выставляют его фото на всеобщее обозрение без его разрешения. Если человек смог сделать снимок, значит, с большой долей вероятности мог сам и подойти. Это было бы менее стрёмно, чем внезапно получить в личку кучу сообщений: «Там человек тебя ищет. Он твою фотку в группу запостил и хочет пообщаться». Не понимаю, что порой движет людьми...

Всё, выговорился, двигаемся дальше.

Также с помощью приложения нашли поджигателей из Петербурга.

Но как насчёт случаев когда приложение использовалось со злым умыслом? Их есть у меня.

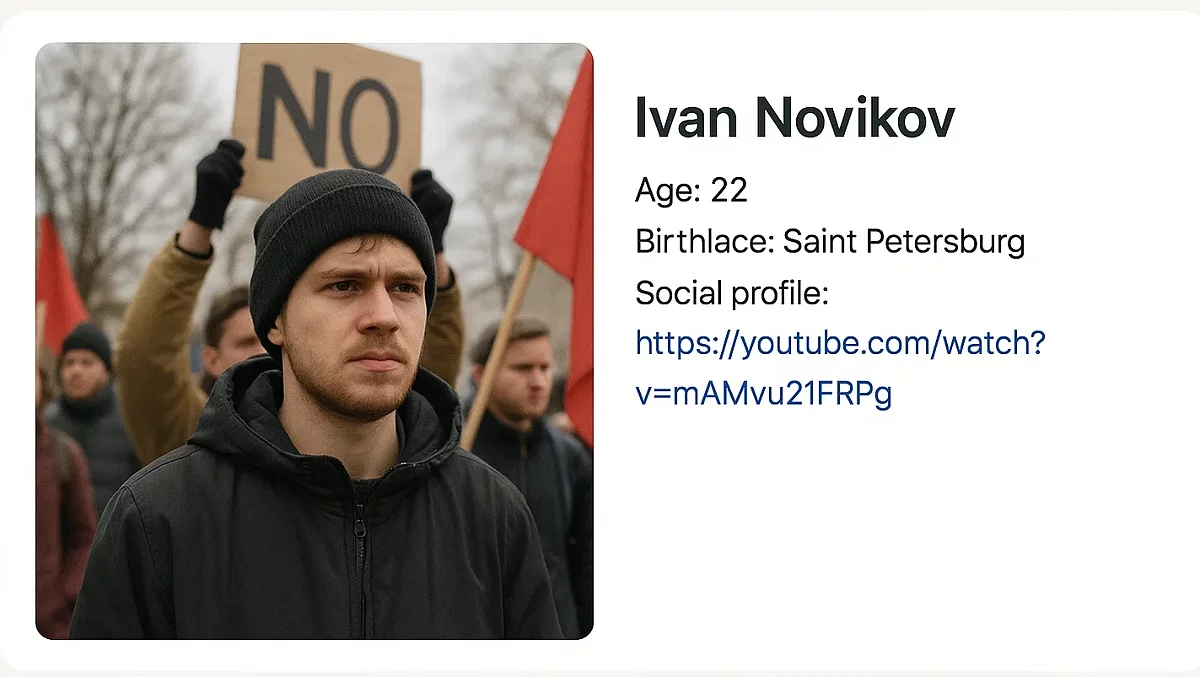

Например, после митингов в 2017 году открылся сайт Je Suis Maidan, на котором деанонились участники таких мероприятий. Там были фото с протестов, ФИО и ссылка на профиль ВК. Сайт уже закрыт и некоторое время пустовал (сейчас его выкупило какое-то казино), но благодаря Wayback Machine можно посмотреть, каким он был раньше.

Фото с мероприятий получали или через камеры, или, возможно, с помощью своих людей, которые снимали митингующих. К примеру, в данном видео неизвестные люди в масках (а на таких мероприятиях, по закону, нужно было быть без них. По крайней мере, в доковидные времена) снимают людей на камеру. А другой участник мероприятия пытается узнать их мотивы.

Максим Перлин (один из основателей сервиса) отрицал связь FindFace и Je suis Maidan. Его слова приводит «Открытая Россия» (сайт более не доступен, но сохранился снимок в веб-архиве).

Мы не имеем никакого отношения ни к этому сайту, ни к протестным акциям. Платформа у нас открытая. Нас не в первый раз обвиняют, что мы стоим за какими-то оскорблениями, шантажом. На это я отвечаю всегда одно и то же — компания, которая производит ножи или Google, или на злобу дня Telegram, не несет никакой ответственности за то, что делают пользователи. Если ножом кого-то порезали, завод в этом не виноват. Поэтому никакого отношения к проекту мы не имеем.

Про неё ещё много всего можно было написать, но тогда опять отойду от темы. Главное мы выяснили: что распознавание лиц используют и для поиска обычных людей.

В 2018 году сервис был закрыт, а NtechLab перешла на корпоративные и гос. заказы (по словам vc.ru).

Кстати, ранее, в 2017 году, NtechLab заняла призовые места в конкурсе Face Recognition Prize Challenge (ссылка тоже на веб-архив. Археологом себя чувствую. Кстати, раз скобки ещё идут, прикреплю ссылку и на полный отчёт о его проведении). Его провёл национальный исследовательский институт (NIST) по заказу и сотрудничестве IARPA. Да, это та государственная организация, которая для датасетов брала кадры из интернета (ну и ещё они, посредством проекта Janus, улучшали методы слежки).

У обычных людей есть ограничения по способам сбора данных. Общедоступные записи уличных камер, соцсети, бесплатные пробивщики лиц (после закрытия FindFace их довольно много развелось), или методы социального «инженерства». Но у государства куда больше инструментов по нахождению человека, в том числе и благодаря ИИ.

А я вас вижу

С 2017 года, в рамках пилотного проекта, систему распознавания лиц от NtechLab подключили к камерам Москвы. Система анализировала в реальном времени изображение с камер и проверяла людей по базам. При обнаружении нарушителя система уведомляла правоохранительные органы. Сама NtechLab на своём сайте пишет, что процесс обработки информации удалось полностью автоматизировать, благодаря чему поиск лиц теперь занимает менее 3 секунд.

Система также использовалась во время чемпионата мира по футболу в 2018 году и, согласно пресс-релизу Ростеха, с её помощью было задержано более 180 правонарушителей.

С годами количество подключенных к системе камер становилось больше, а технологии распознавания лиц улучшались. В 20*кхе-кхе*20 году по камерам выявляли нарушителей режима самоизоляции, а в 2021 — участников митингов.

По состоянию на 2023 год более 60 регионов РФ внедрили подобные технологии, заявляет гендиректор NtechLab Сергей Сучков. Также об успешности распознавания можно судить со слов мэра Москвы Сергея Собянина:

В Москве обработаны миллиарды фото-, видеоизображений и машин, и людей за последние годы, миллиарды. И качество распознавания, к примеру, лиц и машин достигло 99,8% — ну, это практически 100% распознавание.

А как технология распознавания лиц применялась в других странах? Давайте разбираться.

В начале статьи я затрагивал программу Janus, которая была закрыта в 2020 году. Её результаты перетекли в Horus, платформу медиа-аналитики с алгоритмами распознавания лиц. Её использовали для выявления похищенных детей и их похитителей, расследования мошенничества с документами, а также выявлением военных преступлений.

Рекомендую ознакомиться с расследованием FBI, Pentagon helped research facial recognition for street cameras, drones от The Washington Post. Там подробно разбираются документы, обнародованные вследствие судебного процесса между Американским союзом защиты гражданских свобод (ACLU) с одной стороны и Министерством юстиции США, ФБР и Управлением по борьбе с наркотиками (DEA) с другой. ACLU требовала, чтобы были опубликованы документы, касающиеся применения технологий распознавания лиц.

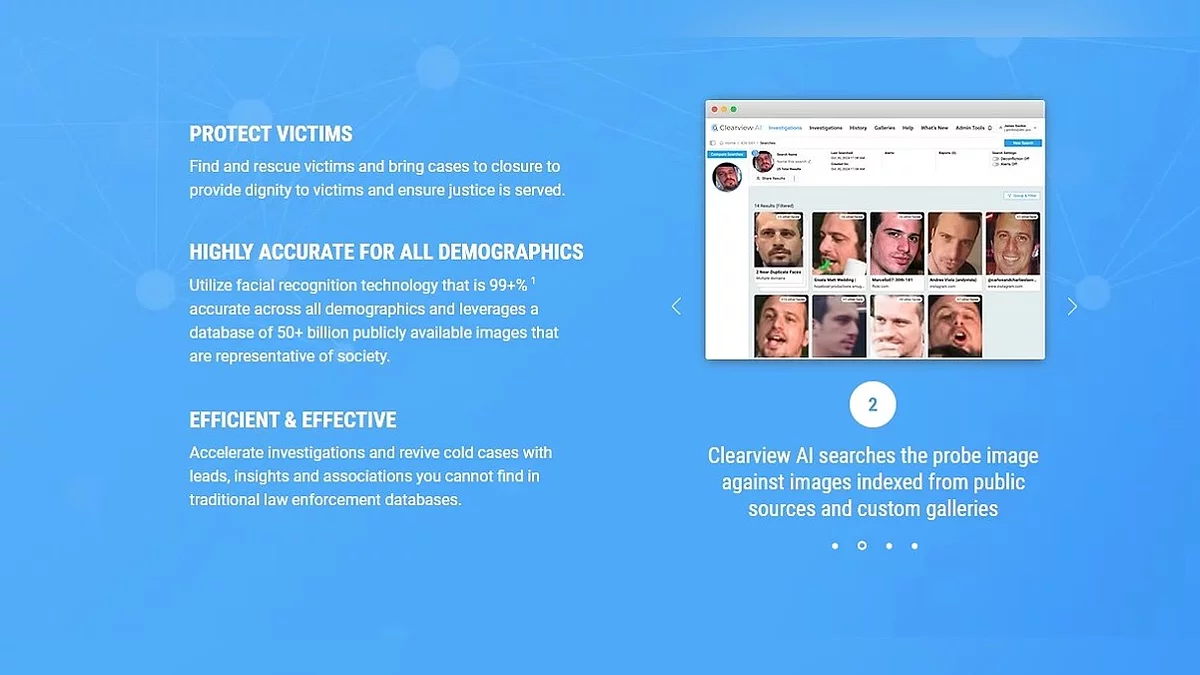

Также в статье упоминается и контракт между ФБР и Clearview AI на сумму 120 000 долларов. Что такое Clearview AI? Так, ничего особенного. Всего лишь частная компания, предоставляющая правоохранительным и гос. учреждениям услуги по распознаванию лиц. Согласно официальному сайту, их база данных состоит из 50+ миллиардов лиц! Данные собраны из открытых источников, таких как новости, вебсайты с фотографиями, соцсети (привет FindFace), а точность распознавания составляет 99+%. Согласно The New York Times, данные собирались в том числе с Facebook, YouTube, Venmo и миллиона других сайтов (примечательно, что на момент написания той статьи, в 2020 году, база насчитывала более 3 миллиардов фото. «За время пути собака база могла подрасти»).

Но как такое возможно? Наверняка же она что-то там нарушает? Да, с ней связано довольно много судебных дел.

Например, в 2020 году ACLU подала иск из-за того, что права жителей штата Иллинойс на неприкосновенность личной жизни были нарушены. В 2022 году стороны пришли к соглашению. Интересно то, как обе организации пишут об этом на своих страницах.

Clearview AI считает это огромным успехом, заверив, что в бизнес-модели никаких значительных изменений не будет, но вину не признали. Также они упоминали, что хоть и так не сотрудничали с правоохранительными органами в Иллинойсе (хотя и могут это делать на законных основаниях), дабы избежать бессмысленных и дорогостоящих тяжб, согласилась в течение некоторого времени и дальше с ними не сотрудничать. Это со слов юриста, который представлял компанию, вот прямая цитата:

Clearview AI is pleased to put this litigation behind it. The settlement does not require any material change in the company's business model or bar it from any conduct in which it engages at the present time. Clearview AI currently does not provide its services to law enforcement agencies in Illinois, even though it may lawfully do so. To avoid a protracted, costly and distracting legal dispute with the ACLU and others, Clearview AI has agreed to continue to not provide its services to law enforcement agencies in Illinois for a period of time.

О, и они сообщили, что согласились выплатить 250 000 долларов адвокатам истца, хотя не считают себя виновными.

В свою очередь, ACLU заявляет, что добились значительных успехов. Благодаря соглашению, компании навсегда запрещено предоставлять свою базу лиц большинству частных компаний не только в Иллинойсе, но и по всей стране. Также жители Иллинойса могут через специальную форму подать заявку на блокировку своих данных.

В пресс-релизе организации есть интересный пункт, в котором Clearview AI запрещается использовать практику предоставления бесплатных пробных аккаунтов отдельным полицейским без ведома работодателя. Т. е. до этого они их предоставляли.

Также компанию штрафовали в разных странах. Нидерланды оштрафовали на 30,5 млн евро, Франция, как и Италия, — на 20 млн евро и т.д. Но эти штрафы или не оплачены или опровергнуты, так как компания не имеет представительств в ЕС.

Но несмотря на то, что компания имеет не самые лучшие отношения с некоторыми странами, она работает не только с США. Clearview AI участвовала в международных расследованиях. К примеру Международным центром по делам пропавших и эксплуатируемых детей (ICMEC) совместно с Clearview AI было идентифицировано 110 жертв сексуального насилия над детьми, благодаря чему были пойманы 8 виновных и спасён 51 ребёнок.

Также компания предоставляет свои технологии Украине, странам Латинской Америки, а до 2020 года и Канаде, но позже там получила запрет на предоставление услуг, который до сих пор в силе.

Благодаря утечке, произошедшей в 2020 году, злоумышленники получили доступ к списку клиентов, количеству аккаунтов, зарегистрированных в сервисе, и количеству поисковых запросов. Благодаря ей стало известно, что на момент утечки компания сотрудничала с более чем 2200 организациями по всему миру, от правоохранительных органов до университетов. Согласно разбору BuzzFeed News, получивших слитые документы, компания работала в 27 странах, включая территории Европы, Южной Америки и Ближнего Востока.

Среди её клиентов указаны ФБР, Интерпол, Управление по борьбе с наркотиками, департаменты полиции, учебные заведения, крупные магазины, банки и даже компании из сферы развлечения, такие как Madison Square Garden и Las Vegas Sands. Большинство из клиентов пользовались бесплатной пробной версией.

Неоднократно были случаи, когда сотрудники использовали Clearview AI, а их начальство даже не знало об этом. Более подробнее об этом документе поговорю в следующей статье (там есть что обсудить).

Кто-то может подумать: «А что в этом плохого? Здорово же, когда полиция нас бережёт. Не делайте ничего противозаконного, и бояться не надо», но для того, чтоб быть обвинённым, не обязательно совершать преступление. Достаточно, чтобы люди, слепо полагающиеся на систему, посчитали вас виновными. Ранее упоминал, что точность распознавания 99%. Но что будет, если человек попадёт в оставшийся 1%? Об этом поговорим в следующей части.

Послесловие

Надеюсь, вам было интересно читать сей текст. При подготовке материала узнал много для себя нового (к примеру, понятия не имел об Clearview AI). Если есть какие-то вопросы, пожелания или конструктивная критика — с удовольствием обсужу в комментариях (неконструктивно я и сам себя покритиковать могу). Надеюсь, следующую часть в течение недели написать. А на этом у меня всё. Всего хорошего, и спасибо за рыбу.

Пост создан пользователем

Каждый может создавать посты на VGTimes, это очень просто - попробуйте!-

![]() Ужасы нейронных сетей. Часть 2: На каких ваших данных обучаются нейросети

Ужасы нейронных сетей. Часть 2: На каких ваших данных обучаются нейросети -

![]() Ужасы нейронных сетей. Часть 3: Как сделать шапочку из фольги или стоит ли опасаться ИИ?

Ужасы нейронных сетей. Часть 3: Как сделать шапочку из фольги или стоит ли опасаться ИИ? -

![]() Ужасы нейронных сетей. Часть 4.5: Clearview AI и ложные обвинения

Ужасы нейронных сетей. Часть 4.5: Clearview AI и ложные обвинения -

![]() Ужасы нейронных сетей. Часть 1: Нейросети и авторское право

Ужасы нейронных сетей. Часть 1: Нейросети и авторское право -

![]() ТОП-205: лучшие кооперативные игры в 2025 году

ТОП-205: лучшие кооперативные игры в 2025 году