Ужасы нейронных сетей. Часть 2: На каких ваших данных обучаются нейросети

ithitym

ithitym

ИИ прочно вошёл в нашу жизнь. С помощью него мы ищем информацию, пытаемся вспомнить забытое произведение, генерируем картинки или просто общаемся. А вы задумывались, как он стал таким умным? В этой статье рассмотрим, откуда они берут данные и какие последствия они за это несут.

Как следует из названия, это вторая часть. Если ещё не видели первую, рекомендую с ней ознакомиться. Напомню, что в ней мы поговорили о типах лицензии, откуда берутся данные для обучения ИИ, кому принадлежит право на сгенерированный контент и о любопытном случае с бесправной обезьяной. Теперь же рассмотрим, какие ваши данные собирают такие гиганты, как Google и OpenAI, для обучения нейросетей и чем это может грозить.

Все «Ужасы нейронных сетей»

- Ужасы нейронных сетей. Часть 1: Нейросети и авторское право

- Ужасы нейронных сетей. Часть 2: На каких ваших данных обучаются нейросети

- Ужасы нейронных сетей. Часть 3: Как сделать шапочку из фольги или стоит ли опасаться ИИ?

- Ужасы нейронных сетей. Часть 4: Генерация и распознавание лиц

- Ужасы нейронных сетей. Часть 4.5: Clearview AI и ложные обвинения

- Ужасы нейронных сетей. Часть 5: Распознавание речи

- Ужасы нейронных сетей. Часть 6: Типы синтеза речи. От Стивена Хокинга до Хатсуне Мику

- Ужасы нейронных сетей. Часть 7: История нейросетевой генерация речи. Часть 1: От поющего IBM до разговорчивой Алисы

Предисловие

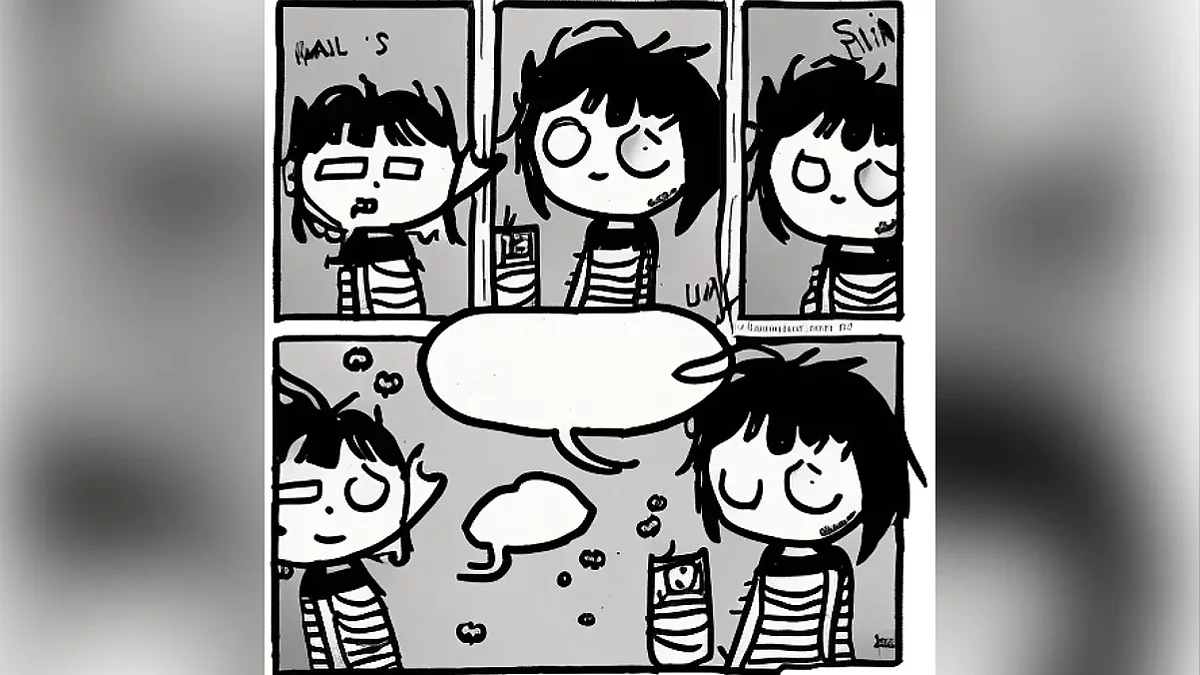

Наткнулся на интересное судебное разбирательство, известное как «Andersen v. Stability AI», в котором художники (включая и Сару Андерсен) подали иск против Stability AI, Midjourney и DeviantArt (по ходу дела какие-то нейронки убирались, какие-то добавлялись). Так как тяжбы ещё продолжаются, не видел смысла сильно на этом акцентировать внимание. Но если интересно, то со всеми юридическими документами и кратким описанием всех важных поворотов в этом деле можете ознакомиться тут.

И ещё одно небольшое (действительно небольшое) отступление.

Некоторые могут сказать: «Пиратство было всегда! Раньше тоже копировали стиль авторов и продавали втридорога», на что отвечаю. Да, всегда были люди, которые копировали стиль другого автора, но они тоже были авторами. Когда копирует другой человек, он всё равно привносит крупицы своей сущности, будь то длина волос, причёска или ширина линий (как в случае с карикатурами на основе работ Сары Андерсен). Порой, даже написав идеальные подделки, он может запомниться в истории. Как например Ван Мегерен.

Но ИИ не может сознательно создать что-то. Это просто алгоритм. Запертый робот в китайской комнате. Он не знает ни одного языка, кроме математического. Получает в окошке запрос и отправляет на выход результат вычислений, который получился в следствии запутанных инструкций. Всё. Он не может по-настоящему думать, не может чувствовать. Не может свои ощущения передать в тексте или на холсте. Это инструмент, но никак не творец (для более детального разбора процесса обучения ИИ очень советую ролик Шарифова на эту тему).

Теперь когда с этим разобрались, можем наконец начать статью.

Большое Число следит за тобой

Поговорим о том, как компании используют наши данные для обучения своих моделей. Начнём, пожалуй, с Google.

По состоянию на 2024 год около 70% людей, владеющих смартфонами, предпочитают Android-девайсы. Мы сохраняем пароли в аккаунте Гугл, проставляем маршруты на Гугл Картах, смотрим и комментируем видео на Ютубе. Даже для обозначения поиска через интернет придумали новый термин — «гуглить». Настолько его сервисы «въелись» в нашу жизнь. Google имеет одну из наиболее обширных баз данных о нас. Кстати, можно запросить экспорт своих данных, чтоб узнать, сколько терабайтов информации о вас накопилось у техно-гиганта.

Но как компания ими распоряжается? Об этом можно прочесть в Лицензионном соглашении и Политике конфиденциальности — куче текста, с которой все соглашаются, не читая. Даже факт использования сервисов «Гугл» означает согласие с написанным в этом документе.

Вот что написано в Политике конфиденциальности (смог найти нужные пункты, только запросив PDF-версию файла).

Мы можем собирать информацию, находящуюся в публичном доступе, чтобыприменять ее при обучении моделей искусственного интеллекта от Google иразвивать такие сервисы и функции, как Google Переводчик, приложения Gemini ивозможности Google Cloud, связанные с использованием AI. Если информация окомпании отображается на сайте, мы можем индексировать ее и показывать всервисах Google.

Какая именно информация находится в публичном доступе? Например, видео и комментарии на «Ютубе» (которые имеют открытый доступ), отзывы на «Гугл Картах» и «Плей Маркете», записи в блоге и т. д. Иными словами, всё, что не приколочено гвоздями приватности. Посмотреть, какие сервисы Google вы использовали и в каком объёме, можно тут. По ссылке можно найти список всех когда-либо установленных приложений, отзывы и сохранённые места на Картах, письма на почте, фото, задачи, данные на «Гугл Диске» и прочее. Я, например, с удивлением узнал, что более 6 лет назад делал пару записей в Blogger (даже успел забыть, что этот сервис существует).

Если вы посмотрели и ужаснулись, настоятельно рекомендую потратить 10 минут для изменения настроек конфиденциальности, чтоб утекающий водопад ваших данных превратился в небольшой ручеёк. Полностью перекрыть «кран» можно, только если не пользоваться ничем, где есть хоть строчка кода, принадлежащая Google. А в идеале — пересесть на луковицу (кто понял, тот понял).

Не пойман — не вор

Теперь перейдём к OpenAI. В последнее время многие начали использовать продукты этой компании для своих целей. Одни воспринимают её как удобную замену Гуглу, другим нравится с ней беседовать, а третьим — создавать картинки, подобные этой.

И не мудрено, что она получила такую популярность. Ведь выдача ChatGPT, по личному мнению, в разы лучше, чем у Copilot. Но как она этого добилась, ведь должны же были исчерпаться свободные клочки информации, разбросанные по интернету. А они и исчерпались. По крайней мере, авторитетные и англоязычные. Потому что, несмотря на неисчислимое количество пользовательского контента на Reddit или X, компании скованы всякими законами и прочими бумажками. Благодаря этому сдерживающему фактору, они не могут внаглую забрать ваш арт для обучения нейросети (за исключением тех случаев, когда могут). Поэтому они идут на разные ухищрения и ищут лазейки в законах.

Об этом заявило издание The New York Times в своём расследовании.

В нём также говорится, что одна из крупных компаний совещалась о сборе работ, защищённых авторским правом. Они рассматривали возможность использования данных со всего интернета, даже если это может повлечь судебные иски. Так как, по их словам, переговоры о лицензиях с издателями, художниками, музыкантами и новостными изданиями займут слишком много времени.

Но вот что много времени не заняло, так это партнёрство OpenAI и Google с Reddit. Ресурс предоставляет контент посредством своего API, а те в свою очередь привносят ИИ-фишки на площадку. Одной из них является Reddit Answers: чат-бот, призванный облегчить поиск информации на платформе.

В статье The New York Times также рассказывается, как OpenAI при помощи созданного инструмента распознавания речи транскрибировала аудио из более чем миллиона часов видео с «Ютуба» (это подтвердили разные источники внутри компании). Расшифрованный текст она «скормила» GPT-4. К слову, после этого Гугл изменил условия, и теперь можно самим давать согласие на обучение сторонних нейросетей посредством ваших видео. По умолчанию всё запрещено, но если хотите разрешить, то следуйте этой официальной инструкции.

По некоторым сведениям, Гугл не остановила OpenAI, так как сама использовала расшифровки видео для обучения своей модели.

Само издание тоже пострадало от действий нейросети. Так, 27 декабря 2023 года The New York Times подала жалобу против Microsoft и OpenAI, утверждая, что миллионы авторских прав были прямо или косвенно нарушены из-за включения их статей в базы данных, на которых были обучены ChatGPT и Microsoft Copilot. Позже дело объединили с исками от других медиа, включая Center for Investigative Reporting. Прения до сих пор идут, так что пока рано делать выводы. Ознакомиться со всеми этапами разбирательств и документацией можно по ссылке.

Пострадали не только контентмейкеры, но и сами пользователи сервисов OpenAI. Так, в прошлом году компания была оштрафована на 15 000 000 евро за использование персональных данных пользователей для обучения ChatGPT без уведомления и разрешения самих пользователей, сообщает издание Reuters.

Горшочек, не ешь!

Вы могли спросить: «А разве не многовато ли данных они поглощают? Когда они наконец „наедятся» информацией и перестанут её поглощать?». Ответ: никогда. По крайней мере, сами компании не намерены сбавлять обороты.

В 2020 году Джаред Каплан, физик-теоретик из Университета Джона Хопкинса, опубликовал новаторскую статью «Scaling Laws for Neural Language Models», которая вызвала большой интерес. В ней он подробно исследовал, как от размера модели и вычислительных мощностей зависит конечный результат. Если вкратце: чем больше — тем лучше. Чем больше информации впитывают модели — тем лучше у них вывод.

Именно с 2020 года и начался бум нейросетей (в расследовании NYTimes, приведённом выше, есть инфографика, рекомендую ознакомиться). Поэтому после исчерпания проверенных и достоверных источников все принялись хвататься за любые данные, произведённые людьми.

Выводы

Нейросети обучаются на ваших видео, комментариях, постах и даже фото, если владелец площадки, где всё это размещено, не против сотрудничества с ними. Если не хотите, чтобы ваши данные были скормлены ИИ, — читайте лицензионное соглашение в сервисах, в которых публикуете контент (но и это не всегда спасает).

В следующей статье разберём, почему опасно делиться с чат-ботом конфиденциальной информацией и какую угрозу это несёт.

Послесловие

Надеюсь, что в следующей серии уже доберусь до самого интересного. А то приступаю за написание и нахожу много материала по теме, от чего вступительный подзаголовок разрастается в полноценный пост. Попытался более кратко обо всём рассказать, но не уверен, получилось ли интересно. Если дочитали до этого момента, поделитесь мнением о статье. О чём бы вы хотели, чтоб рассказал, или где я чего недоглядел. Любая информация извне будет важна. Ну а на этом я с вами прощаюсь. До следующей статьи!

Пост создан пользователем

Каждый может создавать посты на VGTimes, это очень просто - попробуйте!-

![]() Ранний доступ — главное зло современной игровой индустрии?

Ранний доступ — главное зло современной игровой индустрии? -

![]() Ужасы нейронных сетей. Часть 3: Как сделать шапочку из фольги или стоит ли опасаться ИИ?

Ужасы нейронных сетей. Часть 3: Как сделать шапочку из фольги или стоит ли опасаться ИИ? -

![]() Лучшие моды для Kingdom Come: Deliverance 2 на графику, сохранения, хардкор и многое другое

Лучшие моды для Kingdom Come: Deliverance 2 на графику, сохранения, хардкор и многое другое -

![]() DeepSeek обошла ChatGPT и «Шедеврум» по популярности в России

DeepSeek обошла ChatGPT и «Шедеврум» по популярности в России -

![]() Ужасы нейронных сетей. Часть 1: Нейросети и авторское право

Ужасы нейронных сетей. Часть 1: Нейросети и авторское право -

![]() ТОП-70 игр в открытом мире. Вам точно будет, чем заняться

ТОП-70 игр в открытом мире. Вам точно будет, чем заняться -

![]() ТОП-205: лучшие кооперативные игры в 2025 году

ТОП-205: лучшие кооперативные игры в 2025 году -

![]() ТОП-20: лучшие кооперативные хорроры (2021-2025)

ТОП-20: лучшие кооперативные хорроры (2021-2025) -

![]() Лучшие мобильные игры для двоих на iOS и Android (на 2025 год)

Лучшие мобильные игры для двоих на iOS и Android (на 2025 год)