ИИ от Google научился анализировать мир через камеру смартфона

Arkadiy Andrienko

Arkadiy Andrienko

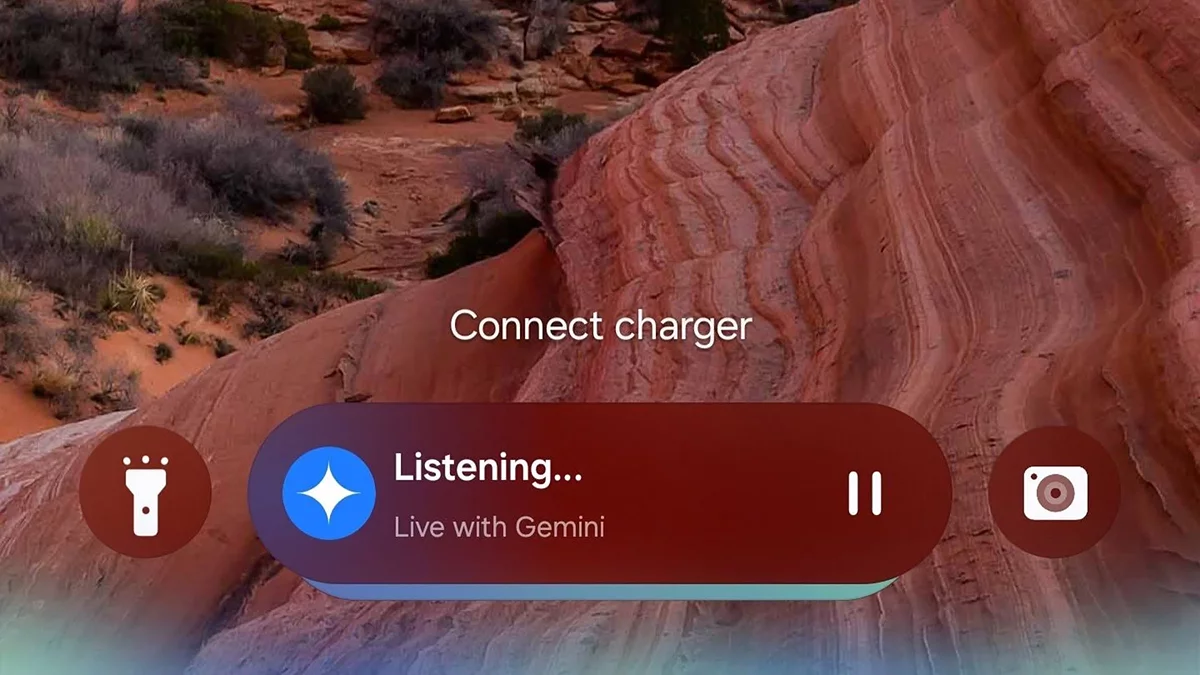

На выставке MWC в Барселоне, Google представила революционные функции для своего ИИ-ассистента Gemini. Уже в марте подписчики премиум-тарифа Google One AI Premium смогут превратить свои смартфоны в «глаза» искусственного интеллекта благодаря двум ключевым опциям — Live Video Analysis и Smart Screenshare.

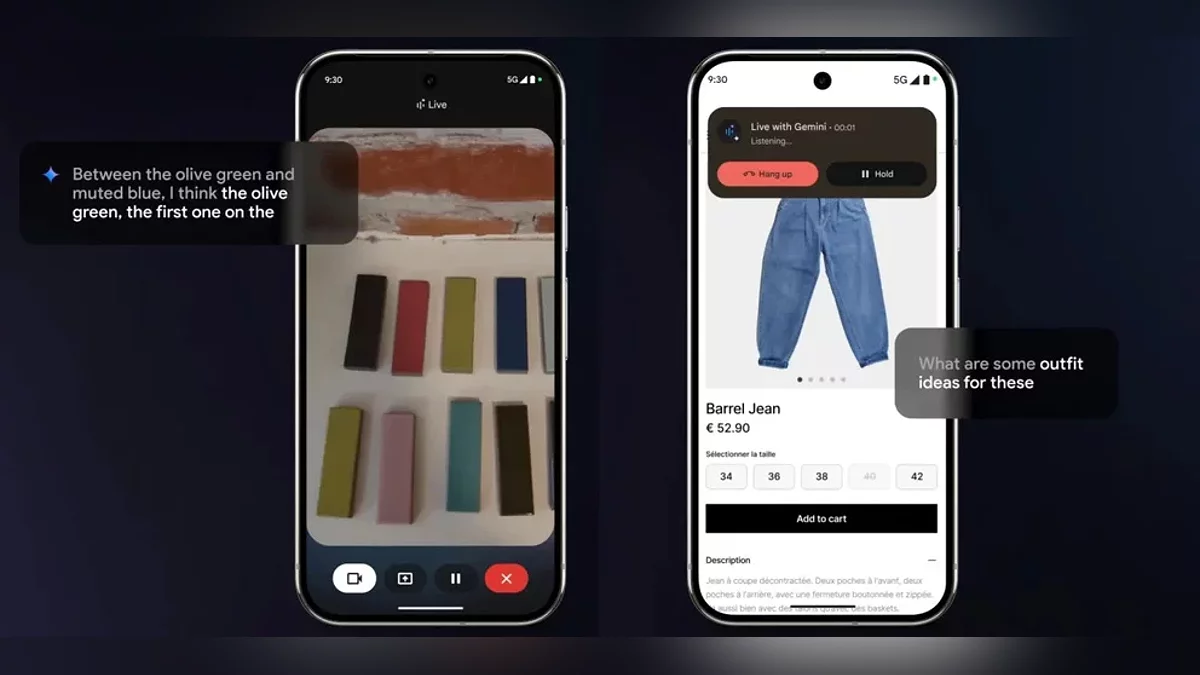

Видеоанализ в реальном времени позволяет ассистенту мгновенно обрабатывать изображение с камеры. Например, навести объектив на предмет гардероба — и получить советы по стилю, или показать интерьер комнаты — и услышать идеи по декору. Gemini не просто «видит» контент на дисплее, но и поддерживает диалог. Пользователь может, к примеру, попросить оптимизировать маршрут в навигаторе или объяснить сложный график в презентации, получая пояснения в формате живого общения.

Интеграция функций пока доступна только на Android-устройствах с поддержкой нескольких языков. На стенде Google демонстрировали работу Gemini на гаджетах Samsung, Xiaomi и других партнёров, подчёркивая кросс-брендовую совместимость. Для владельцев iOS сроки релиза пока не раскрываются.

Заявленные обновления — лишь ступень к амбициозной цели Google под кодовым названием Astra. К 2025 году компания планирует создать универсального мультимодального ассистента, способного:

- Анализировать видео-, аудио- и текстовые данные одновременно;

- Сохранять контекст диалога до 10 минут;

- Интегрировать данные из Search, Lens и Maps для комплексных решений.

Хотя официально о выпуске Astra как отдельного продукта не сообщается, эксперты предполагают, что его функционал поэтапно внедрят в Gemini, усиливая конкуренцию с ChatGPT. Отметим, что нейросеть OpenAI уже с декабря 2023 года предлагает расширенный голосовой режим с анализом экрана, однако Google делает ставку на глубокую интеграцию с экосистемой своих сервисов.

Способность ИИ обрабатывать визуальную информацию в реальном времени стирает грань между цифровым и физическим мирами. Пользователи получают не просто «говорящего помощника», а активного участника повседневных задач — от шопинга до обучения. С запуском Gemini Vision рынок ИИ-ассистентов вступает в эру гиперконтекстного взаимодействия, где ключевым становится не вопрос «как спросить», а «что показать».

Остаётся открытым вопрос приватности: как Google будет защищать данные, передаваемые через камеру и экран. В компании заверяют, что весь анализ происходит с соблюдением строгих стандартов безопасности, но детали станут известны только после полноценного релиза.

-

![]() Google Chrome переходит на автопилот: браузер теперь самостоятельно будет менять скомпрометированные пароли

Google Chrome переходит на автопилот: браузер теперь самостоятельно будет менять скомпрометированные пароли -

![]() Джефф Кейли рассказал как закалялась сталь в Portal 2

Джефф Кейли рассказал как закалялась сталь в Portal 2 -

![]() Google начала «тихую войну» с блокировщиками: популярные блокировщики рекламы перестают работать

Google начала «тихую войну» с блокировщиками: популярные блокировщики рекламы перестают работать -

![]() Enhanced Protection 2.0: Google Chrome представил ИИ-защиту от неизвестных угроз

Enhanced Protection 2.0: Google Chrome представил ИИ-защиту от неизвестных угроз -

![]() Реклама убила поиск: пользователи ищут альтернативы Google

Реклама убила поиск: пользователи ищут альтернативы Google -

![]() Google Play Protect научился распознавать вирусы в реальном времени

Google Play Protect научился распознавать вирусы в реальном времени