Meta представила Llama 3.2 — открытый ИИ с поддержкой изображений и текста

Arkadiy Andrienko

Arkadiy Andrienko

Компания Meta анонсировала выход новой версии своей языковой модели Llama 3.2, всего через два месяца после релиза Llama 3.1. Это обновление знаменует собой первый открытый искусственный интеллект, способный обрабатывать как текст, так и изображения.

С помощью Llama 3.2 разработчики смогут создавать инновационные приложения, включая платформы дополненной реальности с распознаванием видео в реальном времени, визуальные поисковые системы, которые сортируют изображения по содержанию, а также системы анализа документов, способные подготавливать сводки из длинных текстов. Meta утверждает, что запуск новой модели будет простым — достаточно добавить поддержку мультимодальности и наладить взаимодействие с изображениями.

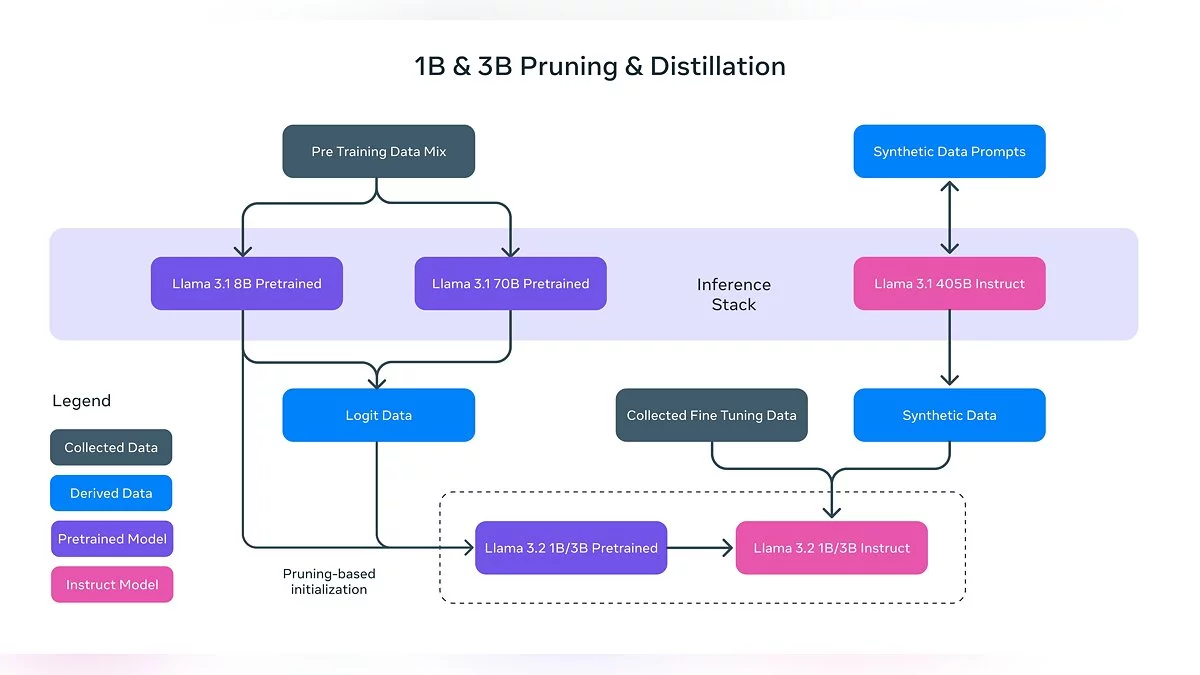

Несмотря на то что OpenAI и Google уже представили свои мультимодальные модели в прошлом году, Meta, похоже, стремится догнать конкурентов. В новой версии предусмотрены две модели, работающие с изображениями (с 11 и 90 млрд параметров), а также две облегчённые текстовые модели (с 1 и 3 млрд параметров), рассчитанные на использование на мобильных устройствах. В то же время предыдущая версия, Llama 3.1, с её 405 млрд параметров, продолжает оставаться сильным игроком на рынке генерации текста.

-

![]() В Skyrim интегрировали искусственный интеллект. Теперь с NPC можно общаться на любые темы, даже на русском языке

В Skyrim интегрировали искусственный интеллект. Теперь с NPC можно общаться на любые темы, даже на русском языке -

![]() Скандал вокруг прослушивания: Google и Meta пойманы на использовании разговоров пользователей для рекламы

Скандал вокруг прослушивания: Google и Meta пойманы на использовании разговоров пользователей для рекламы -

![]() EA хочет натравить на читеров искусственный интеллект

EA хочет натравить на читеров искусственный интеллект -

![]() Искусственный интеллект прошел IQ-тест — похоже, нейросети уже умнее среднестатистического человека

Искусственный интеллект прошел IQ-тест — похоже, нейросети уже умнее среднестатистического человека -

![]() OpenAI выпустила продвинутую модель o1: искусственный интеллект нового уровня

OpenAI выпустила продвинутую модель o1: искусственный интеллект нового уровня