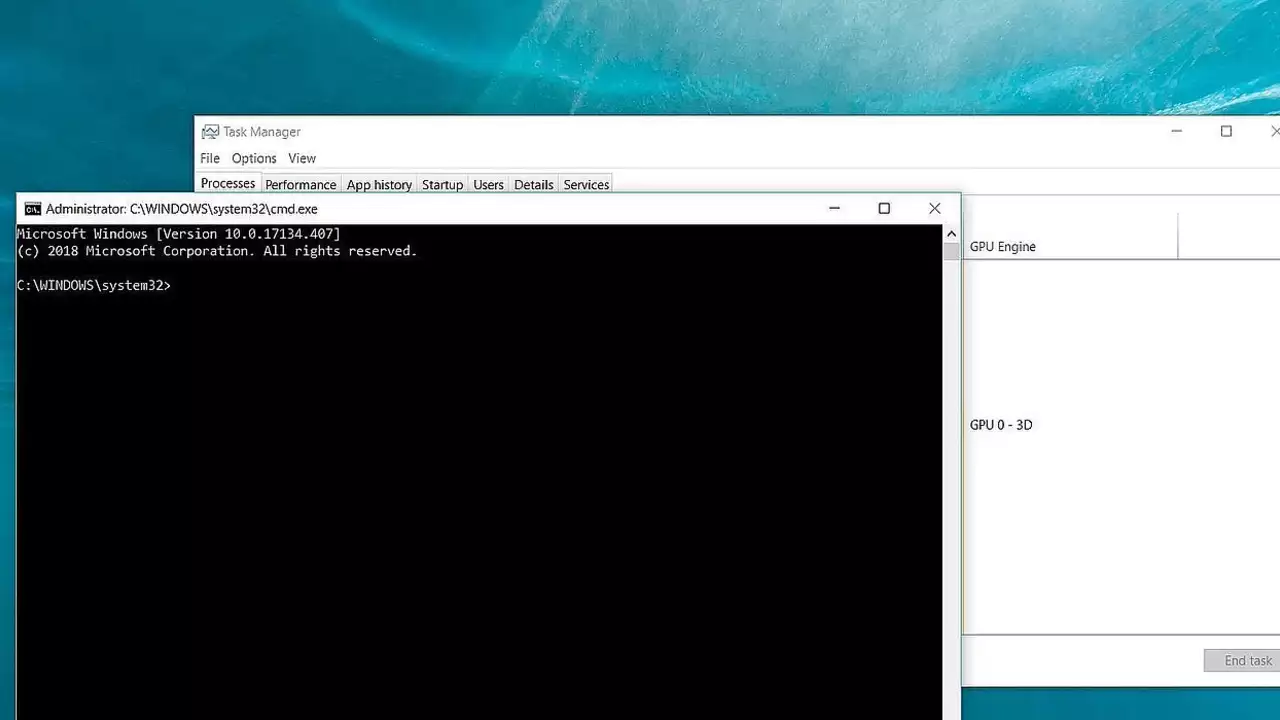

Анализ кодогенерирующих нейросетей выявил неожиданную проблему: модели массово «выдумывают» несуществующие программные компоненты, открывая лазейки для кибератак. Исследователи из Техасского университета в Сан-Антонио проверили 576 тыс. фрагментов кода, созданных 16 популярными ИИ-моделями, включая GPT-4 и Claude. В 19,7% случаев алгоритмы ссылались на фиктивные библиотеки — всего 440 тыс. ошибочных зависимостей.

Злоумышленники могут зарегистрировать пакеты с именами, которые ИИ часто генерирует по ошибке, и наполнить их вредоносным кодом. Когда разработчики установят такие компоненты, не проверив их подлинность, вредоносная программа активируется. В эксперименте тестовые пакеты с вымышленными названиями скачали десятки тысяч раз.

Детали исследования:

- Алгоритмы с открытым кодом (CodeLlama, DeepSeek) ошибались в 22% случаев — в 4 раза чаще коммерческих аналогов (5%). Учёные связывают это с размером моделей: коммерческие ИИ имеют в 10 раз больше параметров.

- javascript уязвимее Python: В первом 21% ошибок, во втором — 16%. Причина — в JS-экосистеме в 10 раз больше пакетов, что усложняет нейросетям подбор корректных названий.

- Повторяемость ошибок: 43% «галлюцинаций» возникали минимум 10 раз. Это упрощает атаки — хакерам не нужно угадывать, достаточно отследить частые «опечатки» ИИ.

Техника Dependency Confusion позволяет подменить легальный пакет вредоносным, используя совпадение имени. Например, злоумышленник публикует в репозитории пакет с трояном. Если ИИ порекомендует его вместо официального, разработчик, не проверив источник, установит опасный код.

Прогноз Microsoft, что к 2030 году 95% кода будет генерироваться ИИ, делает эти рекомендации особенно актуальными. Пока нейросети не научились отличать вымысел от реальности, ответственность за безопасность остаётся за людьми.

-

![]() Microsoft добавит искусственный интеллект в PowerShell

Microsoft добавит искусственный интеллект в PowerShell -

![]() ИИ пишет код вместо людей: Microsoft и Meta* перестраивают разработку

ИИ пишет код вместо людей: Microsoft и Meta* перестраивают разработку -

![]() Искусственный интеллект займётся разработкой законодательства в ОАЭ

Искусственный интеллект займётся разработкой законодательства в ОАЭ -

![]() Зелёная сова увольняет: Duolingo передаёт задачи сотрудников нейросетям

Зелёная сова увольняет: Duolingo передаёт задачи сотрудников нейросетям -

![]() xAI официально выпустила Grok 3 — новый шаг в развитии искусственного интеллекта

xAI официально выпустила Grok 3 — новый шаг в развитии искусственного интеллекта

Arkadiy Andrienko

Arkadiy Andrienko