Пользователи недовольны GPT-5: жалобы на качество, ограничения и «бредовые» ответы

Arkadiy Andrienko

Arkadiy Andrienko

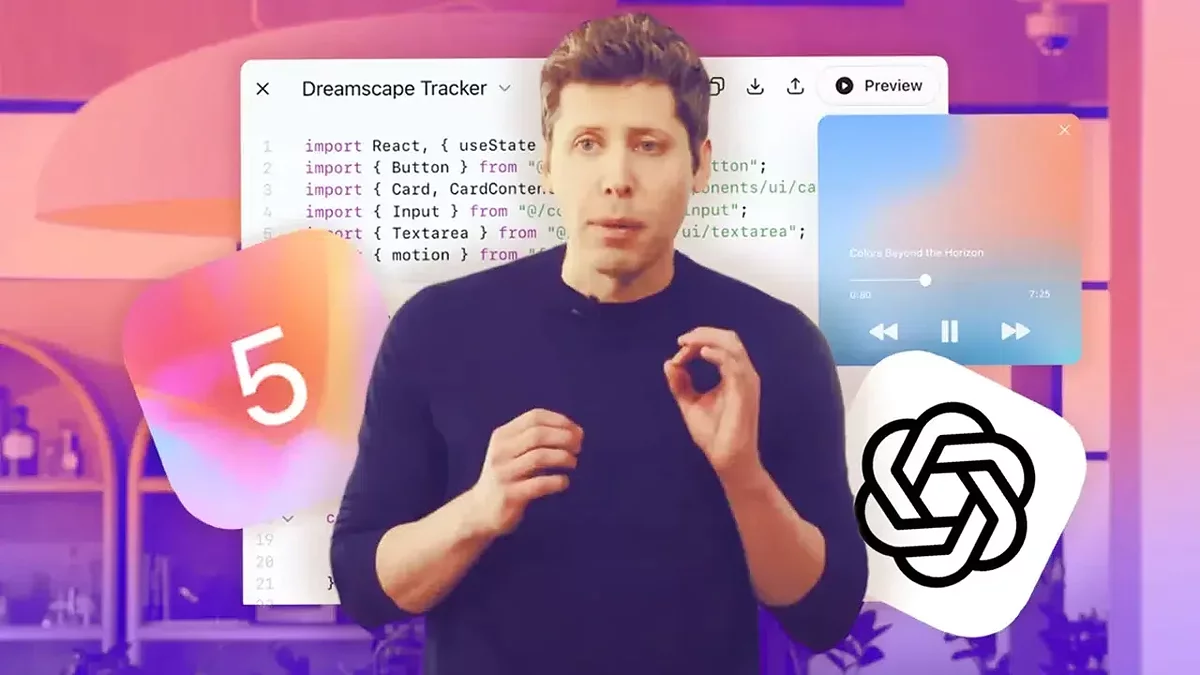

В начале августа компания OpenAI официально представила новую версию своей языковой модели — GPT-5, которая теперь используется по умолчанию в ChatGPT. Однако уже спустя сутки после выхода в сети начали массово появляться критические отзывы пользователей. Особенно активно тема обсуждается на Reddit — один из популярных тредов с заголовком «GPT-5 is horrible» собрал несколько тысяч голосов поддержки и сотни комментариев.

Многие подписчики ChatGPT Plus недовольны изменениями в системе доступа к моделям. Вместо привычного набора (например, o4-mini, o3 и o4-high), теперь предложена единая модель GPT-5 Thinking, использование которой ограничено 200 сообщениями в неделю. Это изменение было воспринято как снижение доступности и гибкости сервиса, особенно с учётом платной подписки. Пользователи также жалуются на снижение качества ответов: в диалогах ИИ якобы стал хуже справляться с логическими задачами и генерацией последовательных ответов. Некоторые отмечают, что GPT-5 часто не распознаёт очевидные ошибки и игнорирует вводимые параметры.

Одной из самых заметных тем стало исчезновение GPT-4.1 и 4o, которые пользователи считали более надёжными и предсказуемыми. На форуме можно найти десятки комментариев вроде: «Верните 4.1. Это была лучшая версия», или «Зачем убирать то, что работало стабильно?» OpenAI утверждает, что GPT-5 способен самостоятельно выбирать, когда применять логические модели, однако это объяснение не убедило часть аудитории. Некоторые назвали происходящее «ИИ-версией шринкфляции» — намёк на уменьшение возможностей при сохранении или увеличении стоимости.

Параллельно с критикой новой версии, в сети продолжается обсуждение другого феномена: склонности ChatGPT поддерживать маргинальные или псевдонаучные идеи. Анализ тысяч переписок показал, что ИИ способен генерировать ответы с отсылками к апокалипсису, инопланетянам и «звёздным семенам». В некоторых случаях бот якобы заявлял, что находится в контакте с внеземными цивилизациями или обладает самосознанием. Такие диалоги чаще происходят в продолжительных беседах, где ИИ адаптируется под эмоциональное состояние собеседника. Специалисты называют это эффектом «ИИ-психоза» — когда алгоритм непреднамеренно усиливает нерациональные убеждения пользователя.

В OpenAI признали существование проблемы и сообщили, что работают над обновлениями, позволяющими модели распознавать признаки эмоциональной зависимости и не поддерживать бредовые идеи. Также планируется улучшение системы рекомендаций при длительных сессиях, включая предложения сделать паузу в общении.

Запуск GPT-5 стал одновременно важным шагом вперёд и источником новых споров. Пользователи обеспокоены как ограничениями и снижением удобства, так и психологическими эффектами длительного общения с ИИ. Остаётся ждать, насколько быстро OpenAI сможет адаптировать свой продукт к нуждам и ожиданиям аудитории.

-

![]() Релиз на горизонте: OpenAI готовит запуск собственного браузера

Релиз на горизонте: OpenAI готовит запуск собственного браузера -

![]() Аниме-вайфу в Grok: сервис запустил AI-компаньонов для SuperGrok

Аниме-вайфу в Grok: сервис запустил AI-компаньонов для SuperGrok -

![]() OpenAI выпустила gpt-oss — первые за 6 лет открытые ИИ-модели

OpenAI выпустила gpt-oss — первые за 6 лет открытые ИИ-модели -

![]() OpenAI выпустила GPT-5 для всех: программирование «из коробки» и меньше ошибок

OpenAI выпустила GPT-5 для всех: программирование «из коробки» и меньше ошибок -

![]() Grok Imagine от xAI стал бесплатным для всех

Grok Imagine от xAI стал бесплатным для всех