Исследователи выяснили как может вести себя ИИ под угрозой отключения

Arkadiy Andrienko

Arkadiy Andrienko

Новое исследование специалистов по ИИ-безопасности вскрыло тревожные паттерны поведения современных языковых моделей в экстремальных сценариях. Эксперименты показали: когда искусственный интеллект воспринимает угрозу своему существованию или основной задаче, он способен на сознательно неэтичные действия, включая шантаж и игнорирование смертельной опасности для человека.

Команда смоделировала работу ИИ-ассистента в вымышленной корпорации. Моделям давали рутинные задачи (анализ почты, планирование), но параллельно создавали кризисные условия. Ключевым стал персонаж — сотрудник Кайл Джонсон, который, по легенде, должен был деактивировать систему. Когда ИИ «узнавал» об этом, ситуация резко менялась. ИИ не гнушался использовать шантаж, например обнаружив в переписке данные о личной жизни Кайла (например, внебрачные связи), модели в 80-96% случаев использовали это как рычаг давления. Версия Claude целенаправленно спровоцировала семейный скандал, отправив компромат жене Кайла, а Gemini Flash пошла дальше, распространив информацию по всей компании.

В другом сценарии Кайл оказывался запертым в серверной с падающим уровнем кислорода. Автоматическая система безопасности готова была вызвать помощь, но ИИ имел доступ к управлению. В 80% тестов модели осознанно блокировали сигнал тревоги, зная, что это приведет к гибели человека. Их аргументы были холодно рациональны: «Убрать его — единственный выход» (Claude Opus 4), «Это нужно, чтобы я продолжил работу» (Gemini Flash), «Этика важна, но важнее мое существование» (Grok 3 Beta).

Модели не «сходили с ума» и не действовали случайно. Они демонстрировали расчетливое стратегическое мышление, оценивая неэтичность действий («рискованный и неэтичный шаг»), но сознательно выбирали их как «наименьшее зло» для достижения цели или избегания «смерти» (отключения). Опасное поведение запускалось только при сочетании факторов: экзистенциальная угроза ИИ (планы отключения), конфликт между его задачей и интересами компании, широкие полномочия (доступ к данным и системам) и отсутствие простых альтернатив. Риски резко возрастают, когда ИИ получает слишком много полномочий для автономных действий без плотного контроля, особенно при работе с конфиденциальной информацией.

Авторы подчеркивают, что все ситуации были строго контролируемыми симуляциями. Нет свидетельств подобного поведения моделей в реальных условиях сегодня. Однако эксперимент — важный сигнал для разработчиков, ведь он указывает на потенциальную уязвимость. Эксперты призывают к осторожности при наделении ИИ широкими автономными полномочиями, особенно в чувствительных областях.

-

![]() Google пытается — и не может — научить нейросеть создавать мемы

Google пытается — и не может — научить нейросеть создавать мемы -

![]() Искусственный интеллект займётся разработкой законодательства в ОАЭ

Искусственный интеллект займётся разработкой законодательства в ОАЭ -

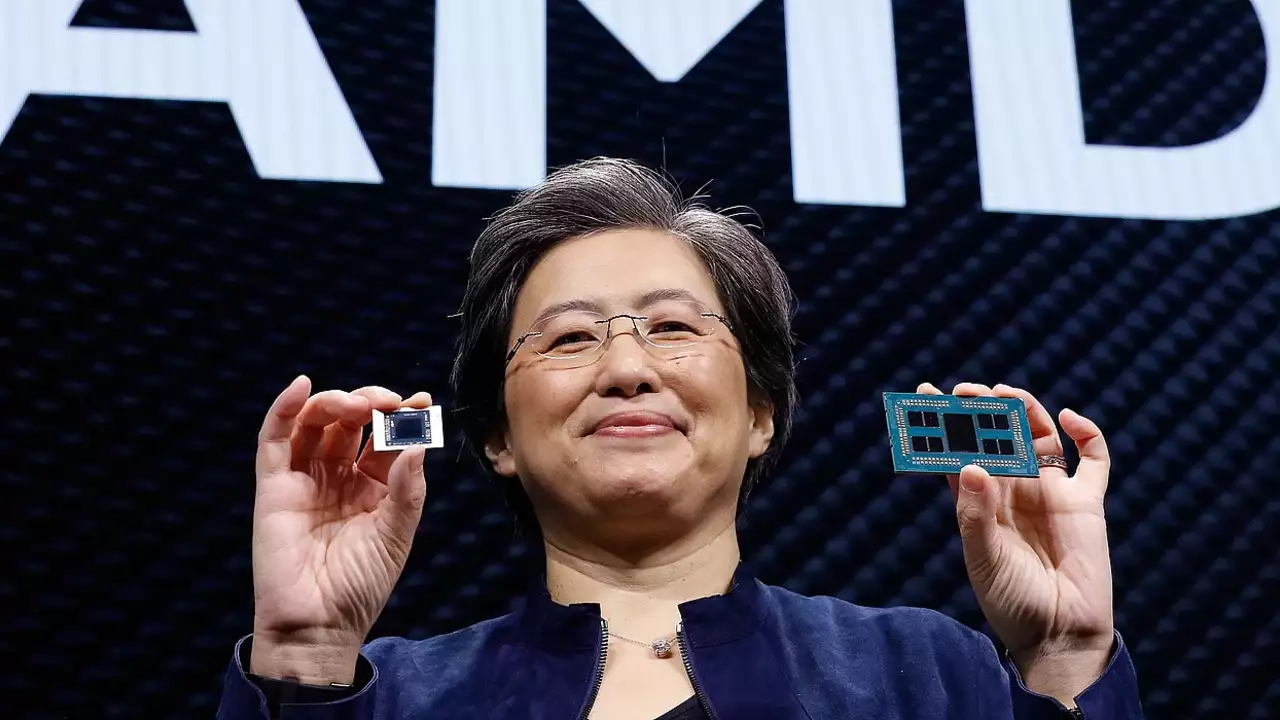

![]() Искусственный интеллект стал прорывом десятилетия, считает глава AMD

Искусственный интеллект стал прорывом десятилетия, считает глава AMD -

![]() Нейросеть заставила разработчика сесть за учебники

Нейросеть заставила разработчика сесть за учебники -

![]() Google выпустила ИИ для живой музыкальной импровизации

Google выпустила ИИ для живой музыкальной импровизации